한국에서는 AI 관련 회사로 SK하이닉스가 자주 언급되며, 특히 HBM 기술이 크게 강조됩니다. 올해 젠슨 황은 엔비디아 B100의 출시를 발표하는 자리에서 한국 업체들의 뛰어난 HBM 기술력을 칭찬하였습니다. 그러나, 엔비디아 서버에서 HBM이 차지하는 비중은 5% 미만에 불과합니다. 또한, HBM의 채택 여부는 엔비디아의 요구사항이 절대적인 역할을 합니다.

이번 글에서는 엔비디아의 향후 GPU 로드맵을 알아보고, 삼성의 HBM3E 12단 메모리가 어디에 납품될 수 있을지 추측해 보겠습니다.

2024년 엔비디아 H200

엔비디아는 AI GPU 분야에서 시장 우위를 유지하기 위해 공격적인 로드맵을 발표했습니다. 매년 새로운 아키텍처를 선보이며 AI 성능을 지속적으로 개선할 계획입니다. 최근 엔비디아는 Blackwell 아키텍처를 발표했으며, 여기에는 B200과 B100 GPU가 포함되어 있습니다. 특히 주력 제품인 B200 GPU는 두 개의 GPU 다이를 고대역폭 10TB/s 칩-투-칩 링크로 연결해 최대 1.4 엑사플롭스의 AI 성능을 제공합니다.

H100 이후, 2024년에는 H200 GPU가 출시될 예정입니다. H200에는 논란이 많았던 HBM3E 칩이 탑재됩니다. SK하이닉스가 주된 물량을 공급하는 제1 벤더로 선정되었고, 마이크론이 제2 벤더로 HBM3E를 공급합니다. 삼성전자의 공급 여부는 5월 현재 확정되지 않았으며, 여러 가지 루머가 혼재하고 있는 상황입니다.

H200 출시 일정 및 특징

NVIDIA H200은 2024년 2분기부터 출하될 예정입니다. 이 GPU는 호퍼 아키텍처를 기반으로 설계되었으며, 144GB의 HBM3E 메모리를 탑재하고 있습니다. HBM3E 8단은 24GB의 용량을 가지므로 이를 6개 GPU와 통합하면 총 144GB의 용량을 가지게 됩니다.

반면, 삼성의 HBM3E 12단은 32GB의 용량을 제공하므로 144GB를 구현할 수 없습니다. 적은 메모리 탑재량과 블랙웰 대비 낮은 성능으로, H200은 예상보다 수요가 적을 수 있으며, 따라서 마이크론과 같은 후발주자가 초기 물량을 납품하기에 좋은 기회가 될 수 있습니다.

2024년 엔비디아 B100

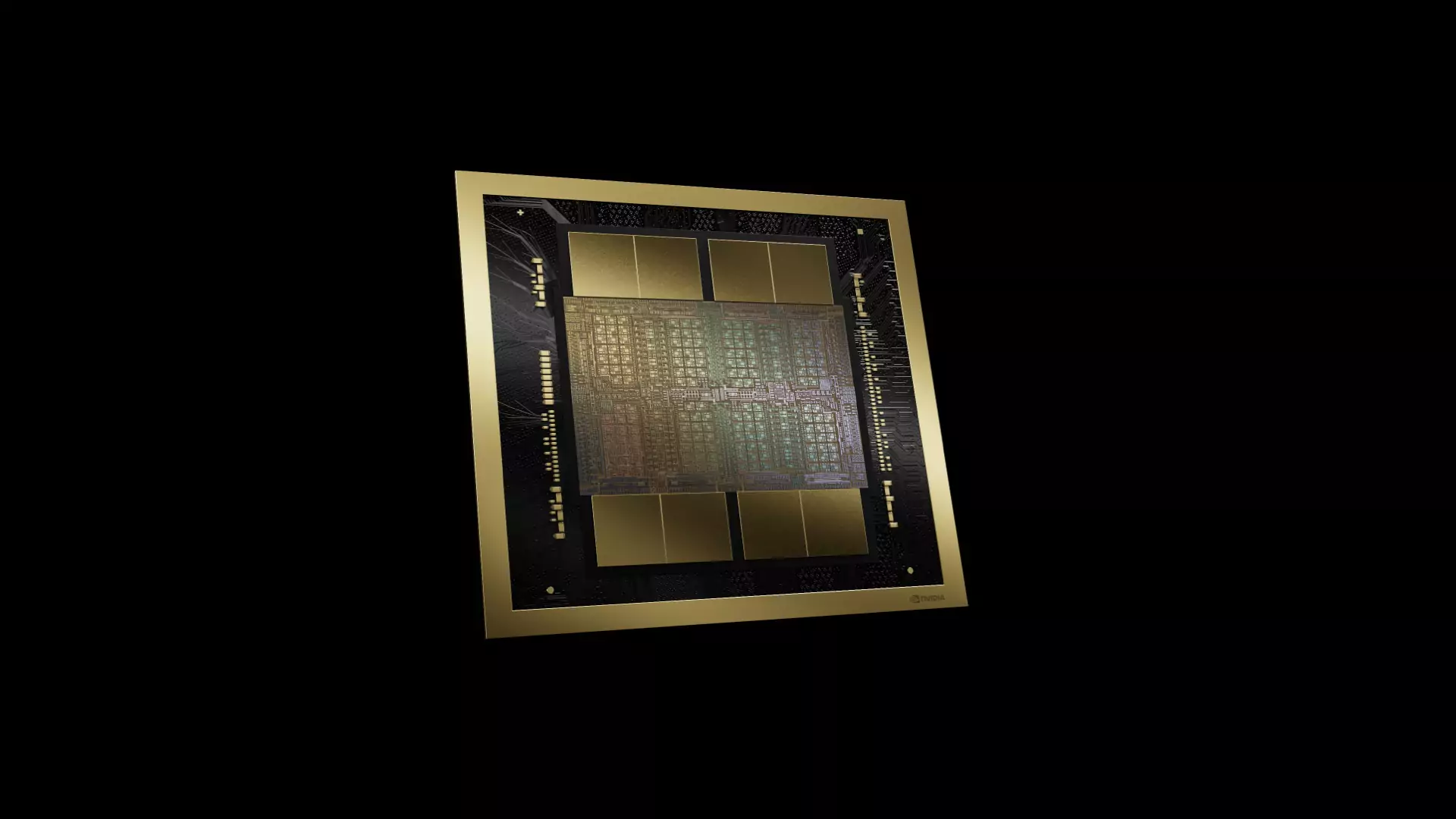

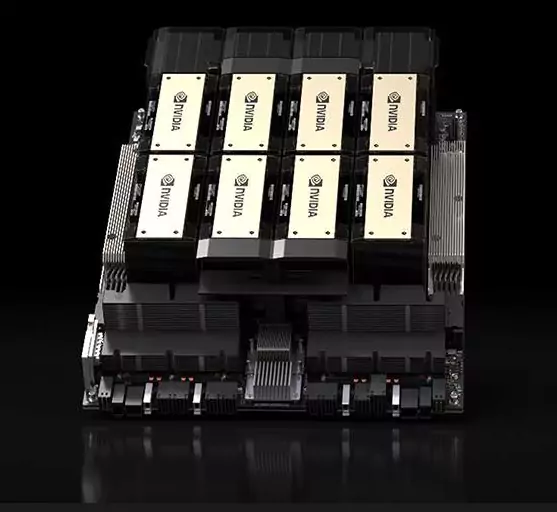

엔비디아 B100 GPU는 블랙웰 아키텍처를 기반으로 한 강력한 AI 가속기로, 차세대 생성 AI와 대형 언어 모델(LLM) 혁신을 이끌어갈 것으로 기대됩니다. B100은 두 개의 블랙웰 GPU 다이를 고대역폭 10TB/s 칩 간 연결로 통합한 듀얼 GPU 디자인을 자랑합니다.

TSMC의 첨단 4nm 공정을 통해 제조된 2080억 개의 트랜지스터가 B100의 심장부를 구성합니다. 대형 언어 모델에 최적화된 2세대 트랜스포머 엔진과 새로운 4비트(FP4) 및 8비트(FP8) 부동 소수점 형식을 지원해 더욱 정교하고 빠른 연산을 가능하게 합니다. 또한, AI 기반의 신뢰성과 예방 유지보수 기능이 내장된 RAS 엔진으로 안정성을 크게 향상시켰습니다.

엔비디아 B100의 성능 및 사양

B100은 현재의 H100 호퍼 GPU를 대체할 NVIDIA의 플래그십 모델로, AI 학습 및 고성능 컴퓨팅 작업에 큰 성능 향상을 제공합니다. 주요 스펙은 다음과 같습니다:

- 아키텍처: 블랙웰 아키텍처

- 제조 공정: TSMC의 최첨단 4nm 공정 사용

- 메모리: 192GB HBM3e 메모리, 8TB/s 이상의 메모리 대역폭

- 트랜지스터 수: 2080억 개의 트랜지스터

- 성능: FP8 및 희소성 작업 부하에서 최대 7 페타플롭스의 AI 성능

- 연결성: 5세대 NVLink 인터커넥트, 1.8TB/s의 양방향 GPU 간 대역폭

- 기능: AI 기반 신뢰성 및 예방 유지보수 기능, 고급 기밀 컴퓨팅 기능, 전용 디컴프레션 엔진

2024년 엔비디아 B100의 장점

엔비디아 B100은 이전 모델인 H100 GPU를 대체하기 위해 설계되었으며, 동일한 700W TDP 환경에서 약 80% 높은 성능을 제공합니다. 이는 NVIDIA의 AI 기술에서 큰 도약을 의미하며, GPT-3와 같은 거대한 모델의 학습과 배포를 훨씬 더 효율적으로 할 수 있게 합니다.

B100은 여전히 대형 언어 모델과 트랜스포머 아키텍처를 기반으로 한 생성 AI 작업에 있어 탁월한 성능을 자랑합니다. FP8 정밀도, 높은 메모리 대역폭, NVLink를 통한 멀티 GPU 확장 등 고급 기능을 갖춘 B100은 클라우드, 슈퍼컴퓨팅, 엔터프라이즈 환경에서의 대규모 AI 배포에 이상적입니다.

B100에 탑재될 HBM3E 경쟁

B100은 새로운 블랙웰 아키텍처를 장착한 첫 제품으로, 전력 효율이 80%나 향상되었기 때문에 상당한 수요가 있을 것으로 기대됩니다. B100은 AMD의 MI300X처럼 HBM3E를 8개 통합하여 192GB의 용량을 보유할 예정입니다.

AMD가 HBM의 채용량을 늘려 트레이닝 뿐만 아니라 인퍼런싱에서도 고성능을 추구하는 전략을 취하고 있기 때문에, 엔비디아가 삼성의 HBM3E 12단 제품을 라인업에 추가하면 패키징을 변경할 필요 없이 256GB의 HBM 용량을 가지는 업그레이드 제품을 선보일 수 있습니다.

결론

삼성의 8단 HBM3E가 H200과 B100의 검증을 통과하지 못했더라도, 12단 제품은 B100의 고용량 버전에 장착될 수 있습니다. 그렇지 않다면, 삼성의 12단 제품은 2025년에 발표될 B200 모델부터 적용될 가능성이 큽니다.

올해 4월 컨퍼런스 콜에서 SK하이닉스는 내년부터 HBM3E(5세대 HBM) 12단 제품의 양산을 시작할 계획이라고 밝혔습니다. 그 이유는 고객사의 수요가 없기 때문입니다. 구체적인 고객사는 언급되지 않았지만, 현재 SK하이닉스가 8단 HBM3E를 공급하고 있는 주요 고객이 엔비디아로 추정됩니다.

만약 SK하이닉스의 주장대로 시장이 형성된다면, 삼성의 HBM3E 12단 제품은 AMD나 ASIC 업체들을 중심으로 채택될 수밖에 없을 것입니다. 그러나 올해부터 AI GPU 시장에서는 인퍼런싱용 수요가 크게 증가할 것으로 보이며, 엔비디아와 AMD 같은 업체들은 이를 위한 제품을 준비하고 있습니다.

이미 MI300X가 증명했듯이, AI 가속기에 HBM 용량이 늘어나면 인퍼런싱에서 더 나은 성능을 발휘할 수 있습니다. 엔비디아는 현재 AI GPU 시장의 80% 이상을 점유하고 있지만, 인퍼런싱 시장에서는 메모리의 중요성이 커지기 때문에 가장 고용량 제품을 무시하고 신제품을 출시할 수 있을지에 대해 의구심이 듭니다.